最近搞了下电影站,需要用到火车头采集工具,类似爬虫,采集各大网站的视频信息并发布到自己的网站。稍微研究了下,别说这火车头功能还真的挺强大,于是就想着可以拿来搞搞事情。

有时候需要下很多网页图片的时候,需要一张张点下载,特别麻烦,于是想用火车头做个示范,直接7*24小时挂机下载。

那么我们就来做个正经(shenshi)的示范吧!

为了满足各位大佬的口味,特地找了个正经(hentai)的网站:http://www.cosplaymore.com/ 我们打开写真。。哦不,cos这一栏,这里示范把整个cos栏里所有的图片都下载到电脑(包括帖子里的图片)。

开始前请先下载火车头采集工具:链接:https://pan.baidu.com/s/1hr5LMRE 密码:olso ,chrome浏览器。

-

分析网页

网页里的东西之所以能被批量下载,是因为有特定的规律,我们要做的就是找到这个规律,并编写规律规则,交给火车头去执行。

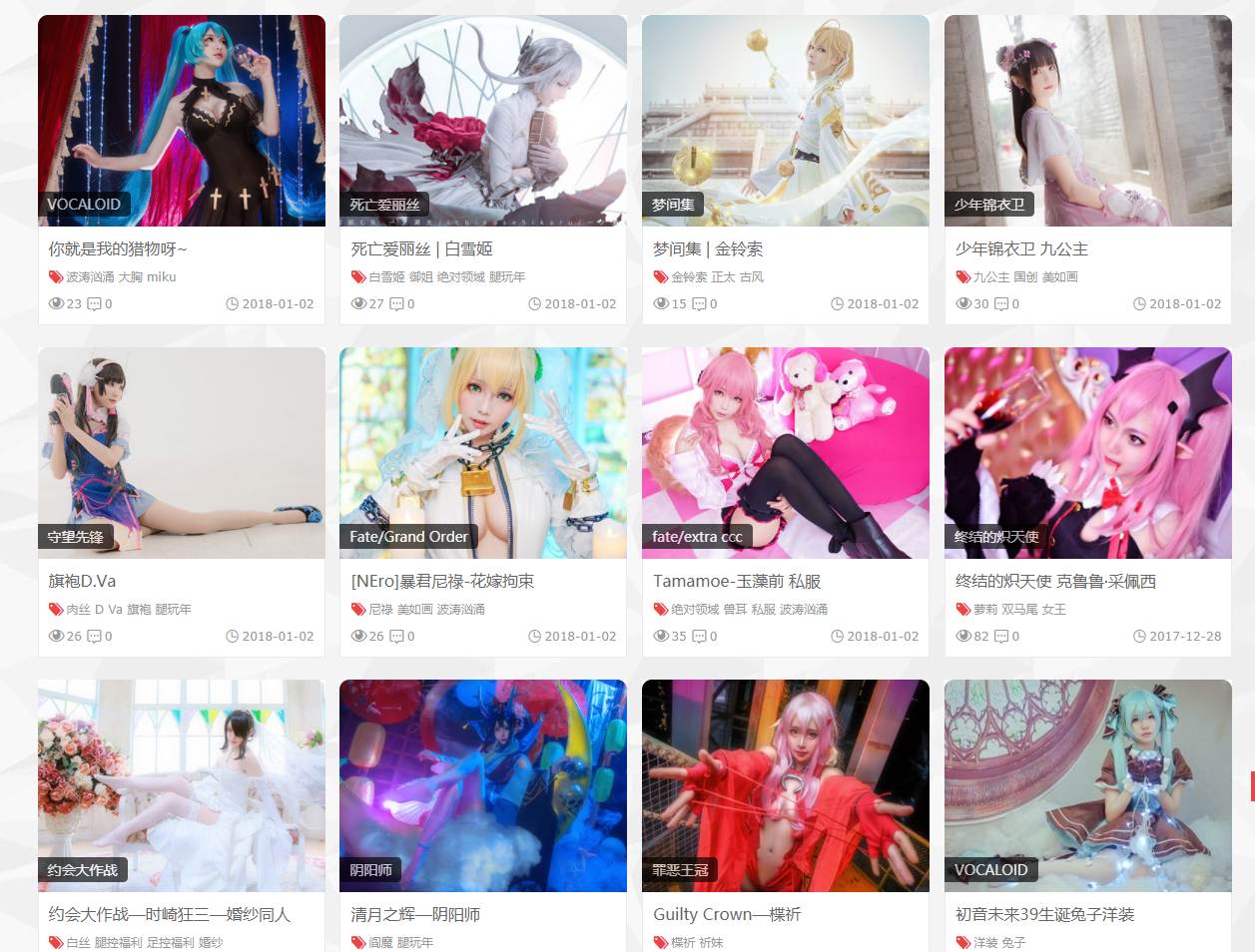

打开网页后点“cos”页面,可以看到分如下区块:

我们要采集的是帖子区域里,帖子里的图片:

所以我们的分析思路就是:找出帖子区每个帖子的链接,然后通过链接打开每个帖子并获取里面的图片地址并下载它们。要完成这个操作,那么就要使用chrome浏览器的F12了。

2.采集帖子地址

-

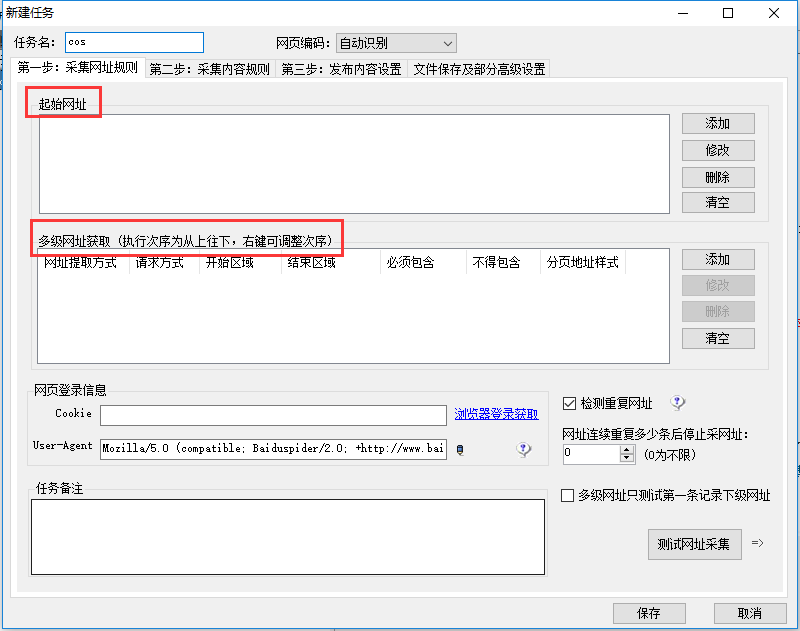

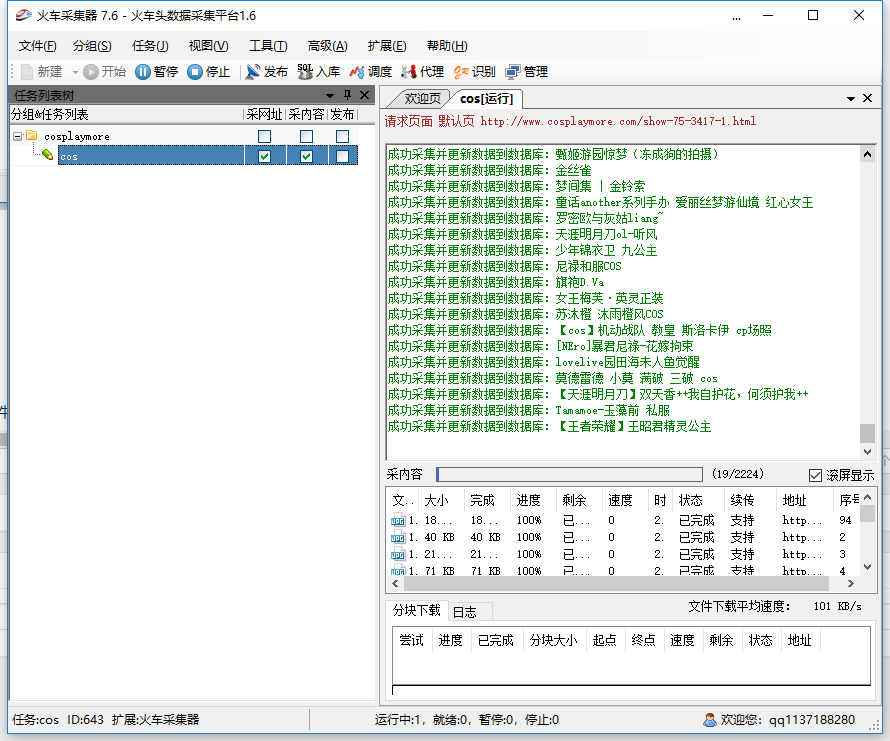

打开火车头采集器,新建一个分组cosplaymore,选中该分组并按“任务”在该分组下新建一个名叫cos的任务。

我们看到有起始网址,多级网址获取这个选项。

-

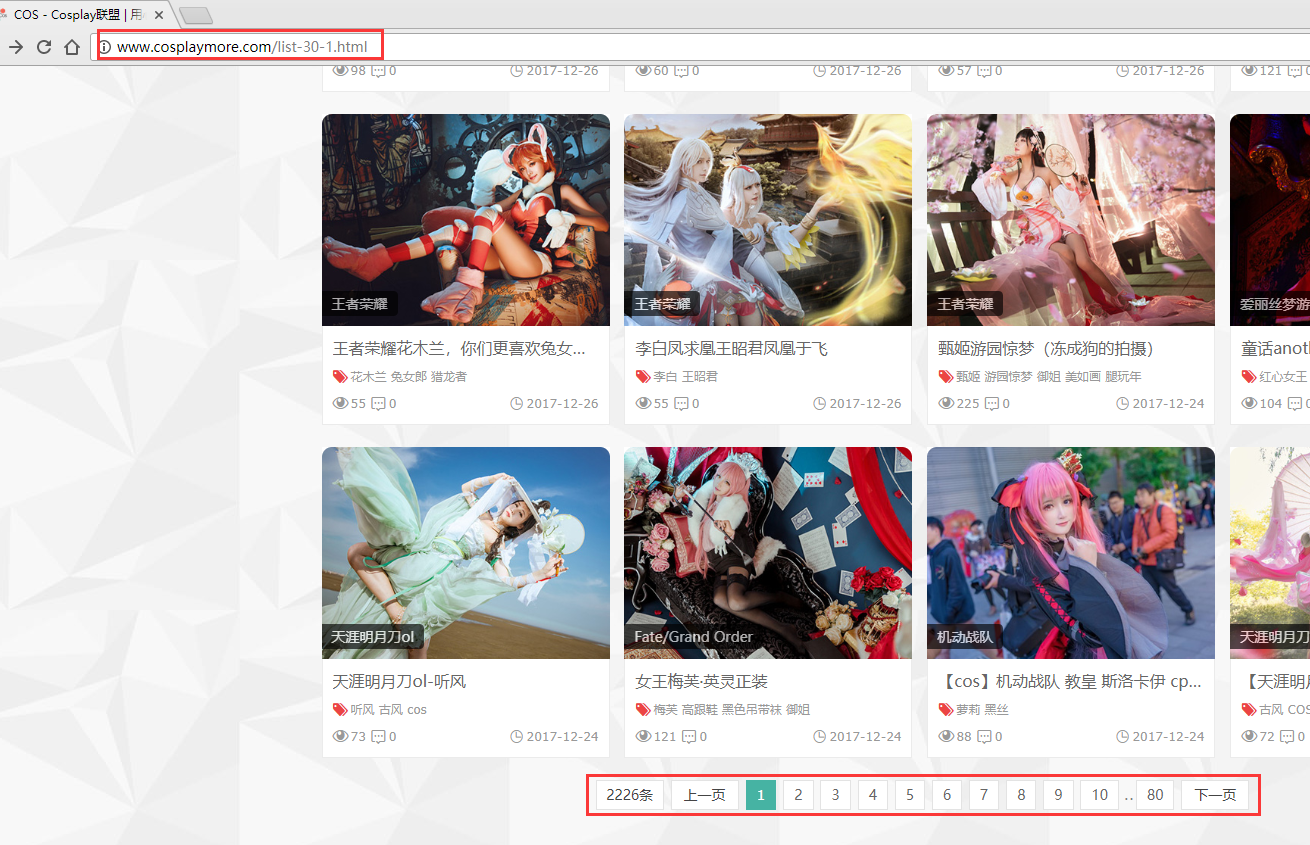

回到我们打开的网页,观察下面翻页和网址:

翻到第二页,这是你会发现网址由http://www.cosplaymore.com/list-30-1.html变成了http://www.cosplaymore.com/list-30-2.html,list-30-x x代表的是当前页数。

-

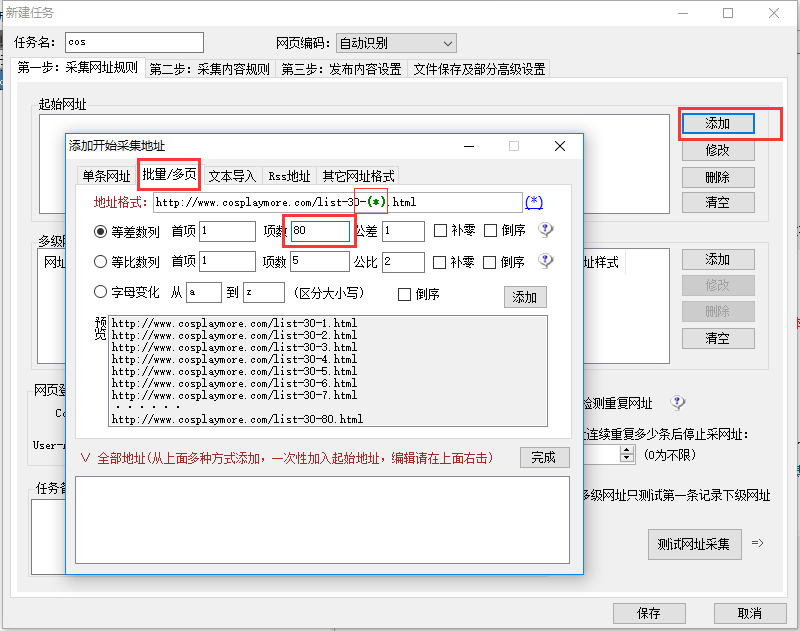

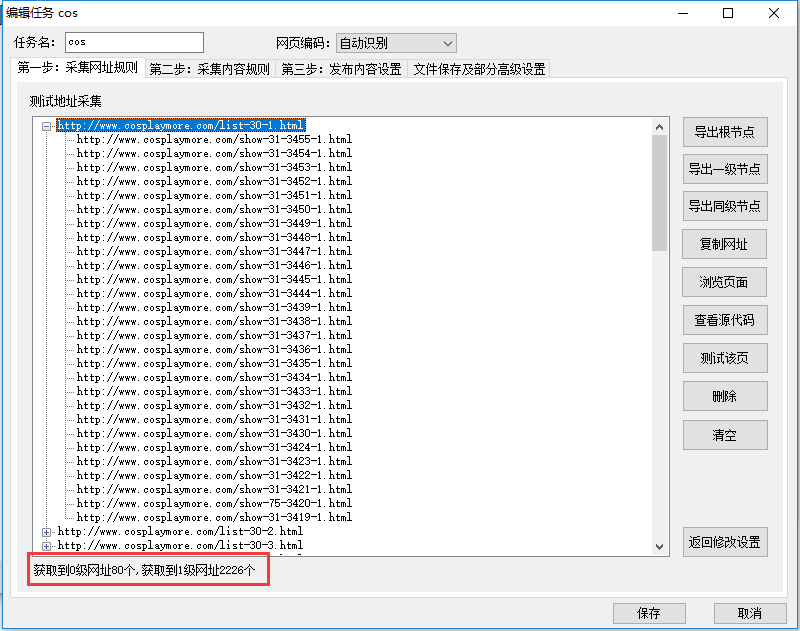

回到火车头,添加批量网址,如图,将 list-30-x 中的页数用(*)这个变量替代,因为一共有80页,所以项数改成80,下面会生成批量地址:

然后再按“添加”加入全部地址。

这样就搞定第一级网址了。

-

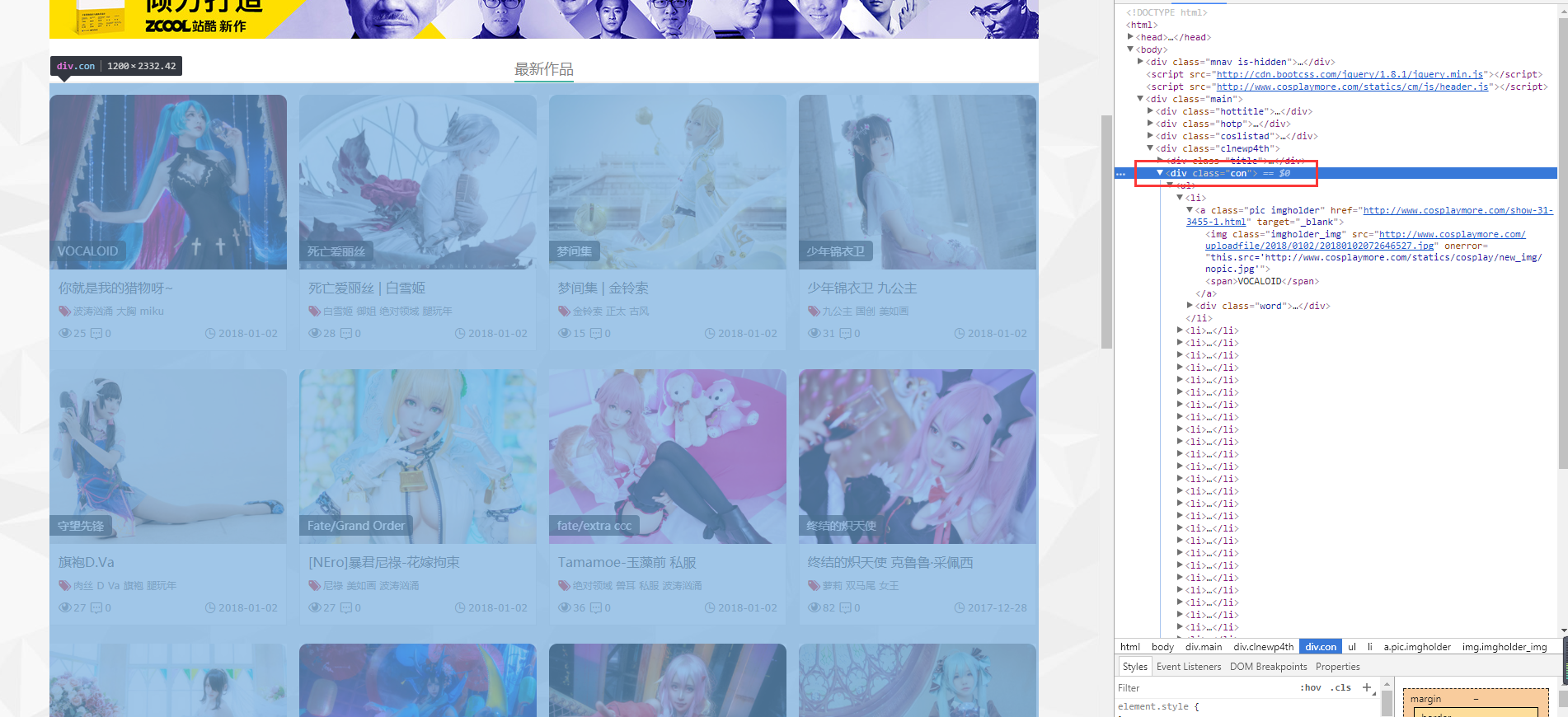

接下来我们获取第二级地址,即所有帖子的地址。按下F12,选中帖子区,移动鼠标至其中一个层(div)时,可以发现整个帖子区都被选中了。

如图我们可以发现整个帖子区是从<div class="con">到</div>的,里面的每个<li>标签就是一个帖子,而<li>标签里href后面就是帖子的地址。

-

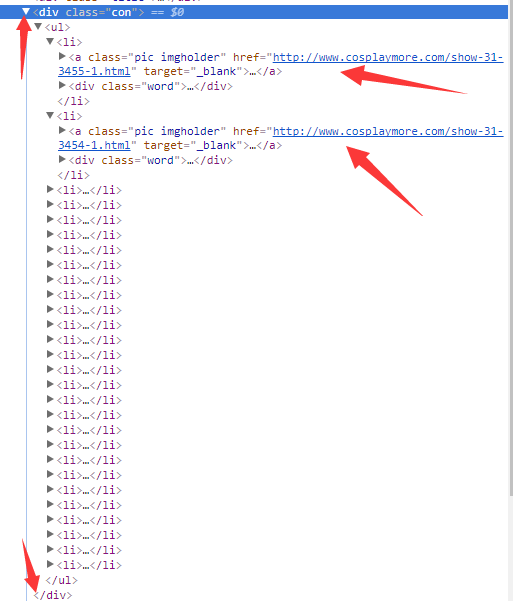

回到火车头,添加多级网址获取–从选定区域获取网址–从<div class="con">到</ul>。为了采集更精确,我们设定网址必须包含“show”。(PS.不能从<div class="con">到</div>,否则每页采集的只有一个帖子地址,至于为什么仔细看下上图就知道了)

-

我们测试一下网址采集,如图,可以看到已经正常获取帖子地址了,80页共有2226个帖子地址。

3.采集帖子内容

这一步也是最终,最重要的一步,将所有的图片都下载下来。

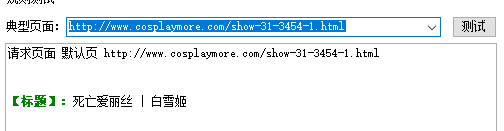

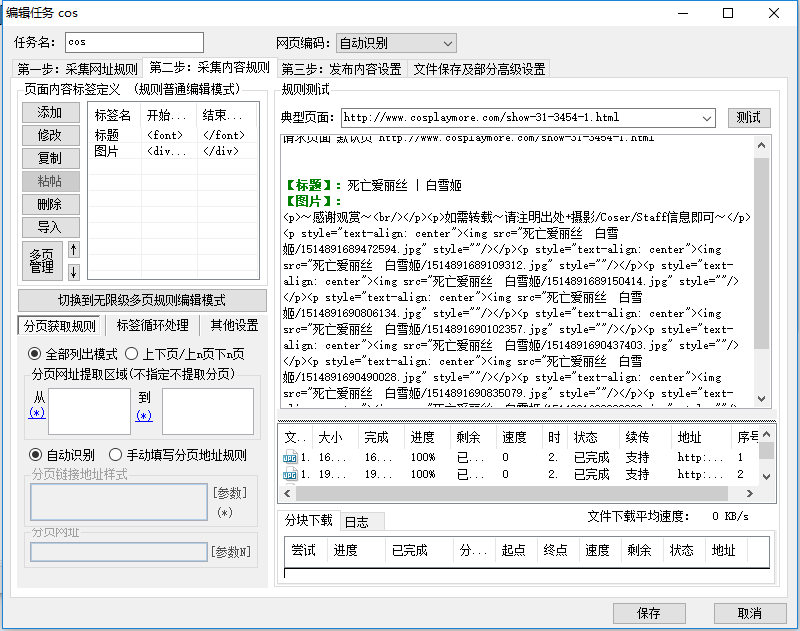

火车头中选第二步,采集内容规则,随便开一个帖子的链接,如http://www.cosplaymore.com/show-31-3454-1.html

-

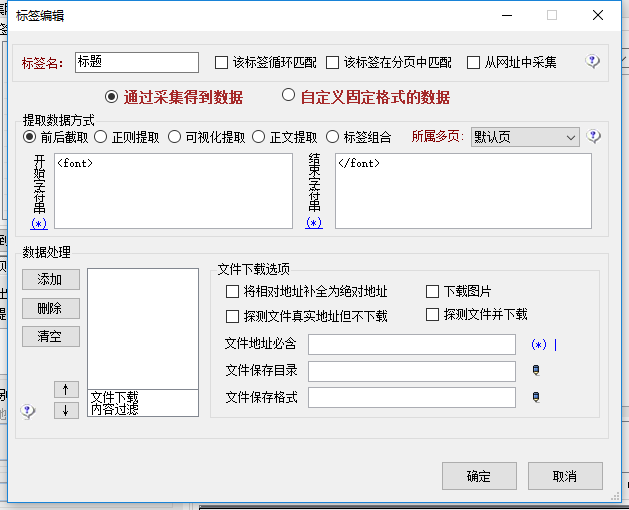

我们先添加一个标题:

如图,右键帖子题目“死亡爱丽丝|白雪姬”检查,可以看到它处于<font>标签中。

回到火车头,添加一个名为“标题”的采集内容,前后截取,开始字符是<font>,结束字符是</font>。

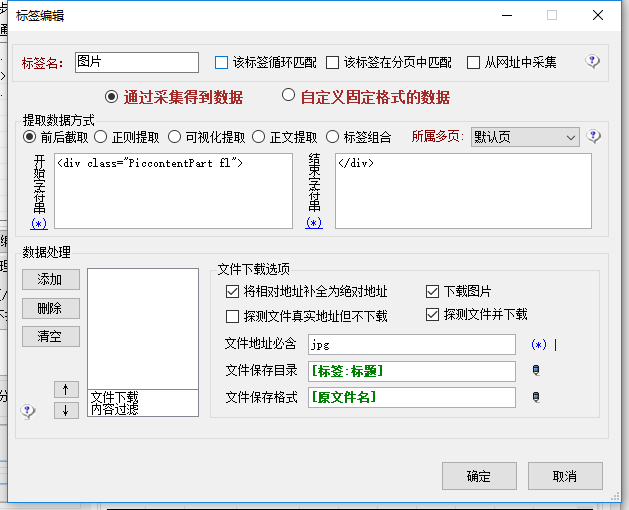

然后把刚才的地址填入右边地址栏《典型页面》中,测试一下采集:

这样就是OK的。

同理你也可以采集时间、作者之类的东西。这里就不演示了,直接说怎么采集图片。

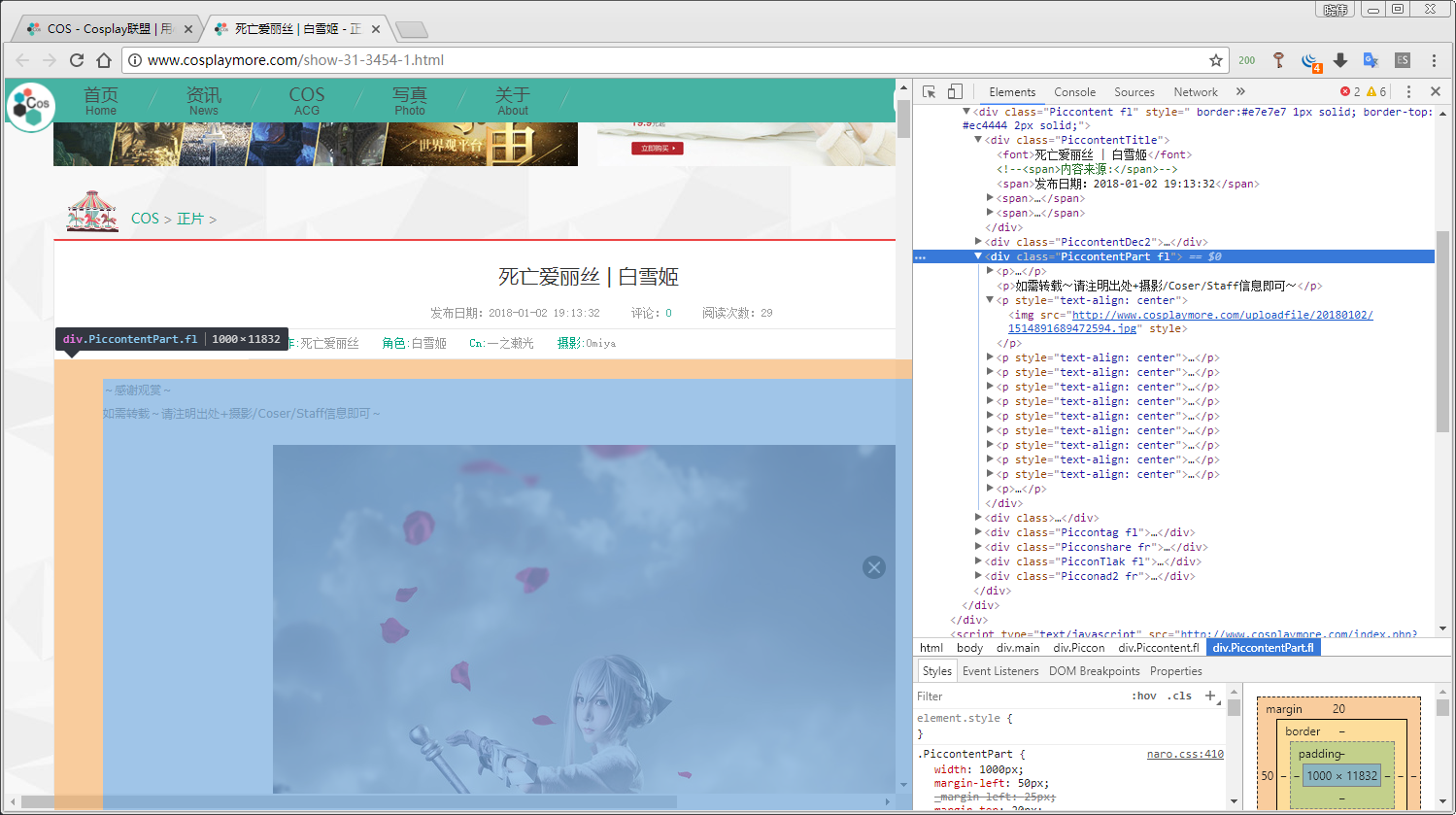

同样F12,鼠标移到<div class="PiccontentPart f1">的时候,整个图片区域被选中了,且每个<p>标签中都有一张图片,地址也在其中,我们要获取的是所有图片的地址。

回到火车头,添加一个名为“图片”的采集内容,如图配置:

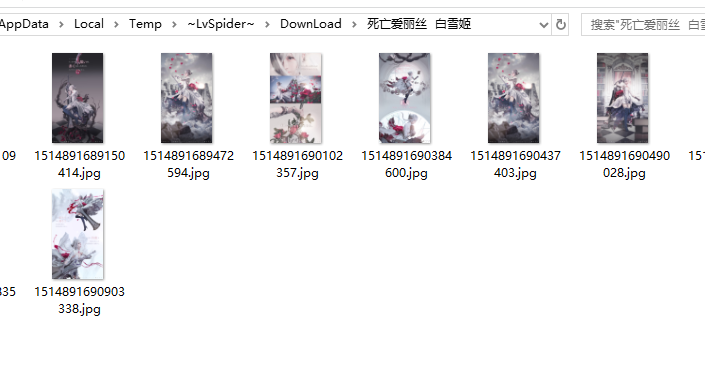

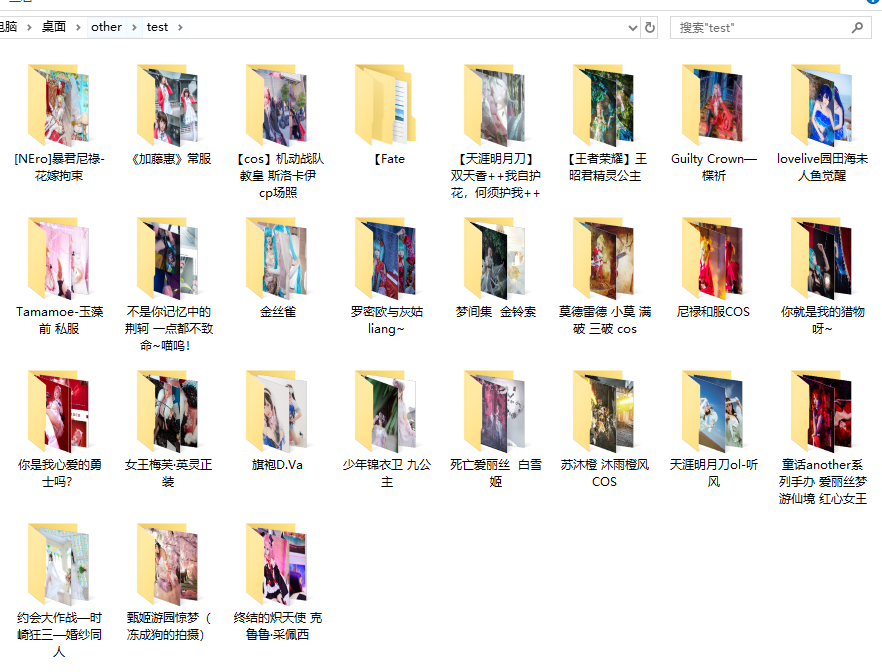

配置完成后出来测试一下采集,发现已经可以自动下载了。并且生成了以帖子标题为名的文件夹。

这里特别提个醒,有些图片的标签不是以 <img src=" 开头的,必须在下方的“数据处理-内容替换”,将<input src等标签替换成<img src 才能识别并自动下载。

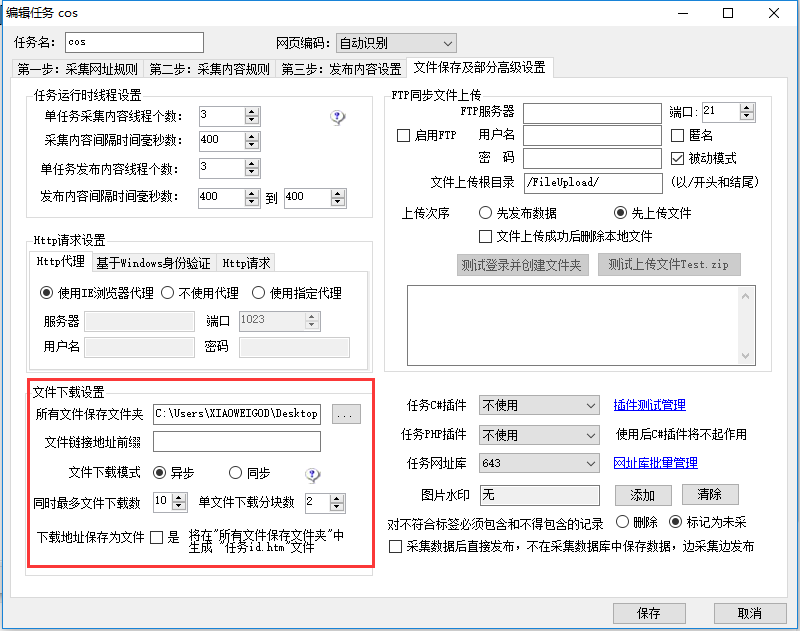

最后设置下图片的保存地址,下载方式异步下载(比较快),其他配置自己看着改。

到这里,整个规则就写完了,这是最简单的规则,对于那些没有太多防范的网站,采集率几乎是百分百。这里也友情提醒下大家,不要去恶意刷人家网站的流量,本次教程也作为演示,对于被测试的网站,我也说句抱歉,大家也不要拿这个网站做测试了。

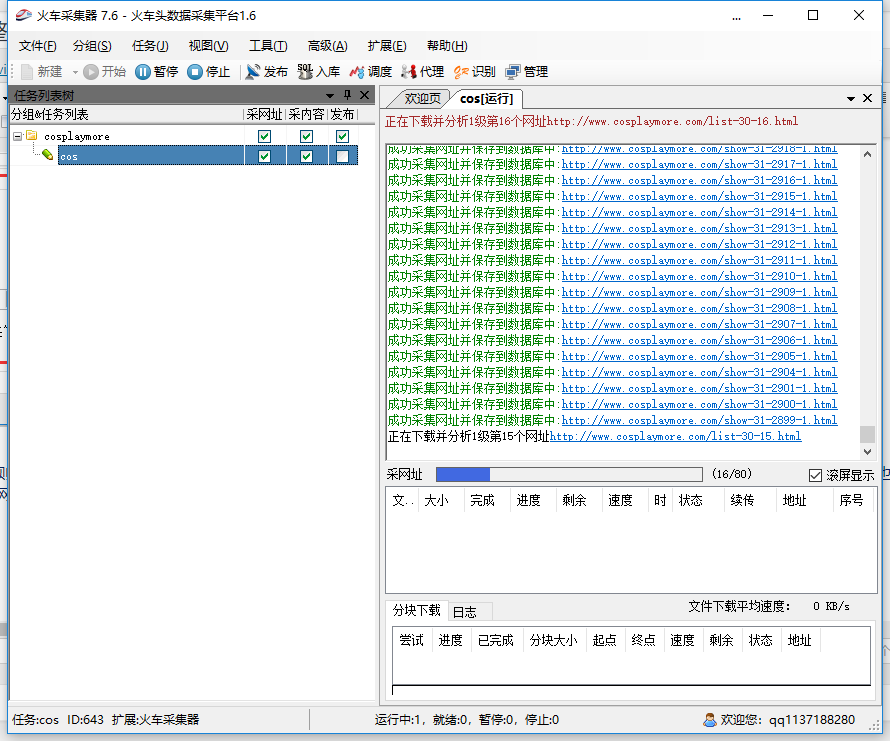

最后我们跑一下看看:

电脑空间不够我就不跑完了。

4.火车头闪退的解决方法

编辑 C:\Windows\System32\drivers\etc 文件夹下的hosts文件,加入如下内容:

127.0.0.1 check.locoy.com 8.8.8.8 check.locoy.com 127.0.0.1 locoy.com 127.0.0.1 file.locoy.com 127.0.0.1 file1.locoy.com 127.0.0.1 log.locoy.com 127.0.0.1 61.191.55.91 127.0.0.1 api.locoy.com 127.0.0.1 121.40.26.57 127.0.0.1 www.locoy.com 127.0.0.1 welcom.locoy.com 127.0.0.1 log8537.locoy.com 127.0.0.1 112.124.118.42:918 127.0.0.1 log11226.locoy.com 127.0.0.1 60.169.1.135 127.0.0.1 .locoy.com 127.0.0.1 .locoy.com 127.0.0.1 61.191.55. 127.0.0.1 file2.locoy.com 127.0.0.1 file3.locoy.com 127.0.0.1 file4.locoy.com 127.0.0.1 file5.locoy.com 127.0.0.1 file6.locoy.com 127.0.0.1 file7.locoy.com 127.0.0.1 file8.locoy.com 127.0.0.1 file9.locoy.com 127.0.0.1 file10.locoy.com 127.0.0.1 61.191.55.91:818 127.0.0.1 update.locoy.com 127.0.0.1 120.26.85.60 127.0.0.1 60.174.233.104 127.0.0.1 220.181.131.230

你好,感谢分享,请问下有分页的,规则怎么写?很多图片站,一张图就分页的,怎么才能全部采集

现在在用python写了 火车头太弱了我已经放弃了